9月1日上午消息,百度2016年世界大会今日举行,本次百度世界大会以“人工智能”为主题,百度公司创始人、董事长兼CEO李彦宏围绕人工智能发表了主题演讲,李彦宏认为互联网即将开启以人工智能为核心的下一幕,而且强调:人工智能将是百度核心中的核心。

李彦宏称,互联网的人口红利期已经结束。他表示互联网发展经过了两个阶段,即PC互联网和移动互联网两个阶段,这两个阶段的发展依赖于人口红利。但现在来说,互联网的增长无法依靠人口红利来驱动。

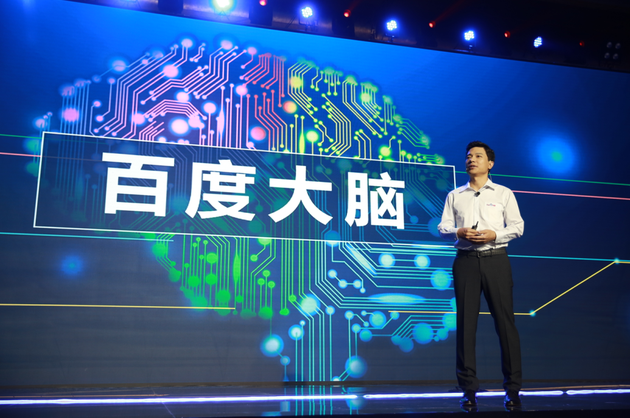

对此,李彦宏认为人工智能是移动互联网的下一幕,并且人工智能将是百度核心中的核心,具体来说,人工智能对百度意味着百度大脑。

目前,百度大脑主要包含三个方面,即算法(神经网络、参数和样本训练)和计算能力(服务器和GPU集群),以及大数据(网页资料、搜索数据、图像视频数据和定位数据)等。

这位百度创始人称,百度大脑将围绕以上三个方面,从四个能力展开应用。包括:自然语言的处理、语音识别、图像识别处理以及用户画像等能力。具体落地应用方面,目前百度语音识别准确率达97%,已经可以用于客服和销售方面,帮助这些语音相关的行业实现提高。语音合成方面,则可以做到原音复现,李彦宏现场以张国荣声音合成举例,合成了张国荣的国语声音,李彦宏还称,目前可以通过50句话的录制,让每一个人都能拥有属于自己的声音模型。

图像识别方面则主要用于四个方面,首先是人脸识别,通过捕捉人脸关键点,形成人脸表情网,实现人脸的准确识别;其次是被应用于百度地图等方面,百度地图与图像智能识别技术的结合,可以让数据无限逼近现实世界;此外,最关键的使用在于百度无人驾驶,利用计算机视觉,可以加快无人车的研发。最后,图像识别还将应用于AR领域,可以提高广告主的营销效果。

自然语言处理方面,主要应用是度秘。核心是通过机器人对于人的语言的理解,用人的语言来实现人机交互。李彦宏称,在最近的奥运会比赛中,度秘实现了对于篮球比赛的解说。实际上,除了运动解说,百度还将度秘应用在了肯德基点餐等方面,目前已在上海开设了概念店。除了语言理解,百度还在机器翻译方面应用了自然语言处理方面,目前可以直接翻译27种语言。

用户画像方面,主要分为通用个性化画像和垂直行业画像两个方面。李彦宏以百度资讯的推荐阅读量举例,使用了个性化画像后,2个月内阅读量提高了10倍,千人千面的个性化阅读体验可以不断被加强。此外,百度还用到了票务销售中,可以精准判断目标用户群体实现销售转换,比如前段时间的《魔兽世界》,就有和百度在用户画像方面展开合作。

最后,李彦宏称百度大脑会将以上四个方面的能力不断结合,也会全部开放共享,实现各个领域的“因智而能”。李彦宏最后强调:人工智能将会让人重新想象中国的经济发展和未来。(李根)

以下为演讲实录:

Robin:各位来宾大家早上好!欢迎来到2016百度世界。

大家知道,百度世界是我们每年举办一次的百度技术创新大会。今年的主题我们聚焦在人工智能,大家在之前收到的请柬上已经看到这个主题了。刚才开场视频是以人工智能为主题的,今天我的主题演讲也将围绕着人工智能来展开。

今年6月份,我在百度联盟峰会上讲了一个概念,叫做互联网的下一幕。下一幕是什么意思呢?就是说,互联网的发展在此之前已经经过了两个非常重要的阶段,第一个阶段大概持续了十几年的时间,就是我们讲的PC互联网阶段。第二个阶段是在最近四五年,我们把它叫做移动互联网的阶段。对于中国市场来说,随着上网人数越来越多,上网人口的渗透率越来越高,现在已经达到了七亿多,就是说已经超过了50%的渗透率,同时,每一个上网的人现在也基本都用上了智能手机。这意味着什么呢?这意味着,未来互联网的增长不能再靠人口红利来驱动了,也就是说,移动互联网的时代其实正在离开我们。这可能是很多人觉得难以接受的。我们国家现在进入了所谓的新常态,经济的增长需要靠“互联网+”行动计划来推动,所谓“互联网+”就是希望用互联网的思维方式、互联网的效率来推动各个行业、产业的继续发展。但是,我们互联网的从业者其实又深深地感受到了这其中的危机,这个危机就是因为过去的粗放增长阶段已经结束了。

移动互联网之后的下一幕是什么?其实现在已经很清楚了,就是我们所说的人工智能。人工智能对于百度来说是核心当中的核心,我们也很幸运,在过去的五六年当中,百度花了很大很大的精力投入到人工智能的研发当中。人工智能对于百度来说意味着什么呢?我可以用简单的四个字来描述,就是百度大脑。百度大脑的概念我们其实在大约三年前就对外讲过。那个时候我们讲,百度大脑已经具备了大概两三岁孩子的智力水平了。自此以后,不断的有人来问我,尤其是今年人工智能突然火起来了之后,很多人来问我说,你们这个百度大脑现在相当于多少岁人的智力水平了。

要回答这个问题其实还蛮难的,我也不知道它现在是多少岁了,因为毕竟人脑和电脑它还是有很大的区别,百度大脑虽然是一个人工智能的大脑,但是它和人正常的发育的过程还是很不一样的。

百度大脑到底由什么构成的呢?它基本上是由三个大的部分组成的。第一个组成部分,就是人工智能的算法。我们有超大规模的神经网络,这是模拟人的神经元组成的网络,但其实我们也不知道真正人脑工作的原理是什么,只是想象当中应该是这个样子。我们还使用了万亿级的参数,人脑的神经源大概是千亿级的,我们也有千亿的样本和千亿的特征进行训练。整个这些东西组成了百度大脑当中算法的部分。

百度大脑的第二个组成部分是我们计算能力。现在我们已经使用了数十万台的服务器来进行计算,而这当中很多的服务器不是传统基于CPU的服务器,而是基于GPU。早年的时候,GPU主要在游戏等领域使用得比较广泛,在人工智能、尤其是深度学习起来以后,我们发现,其实GPU特别适合人工智能的计算,尤其是深度学习的计算,一块GPU可以顶100个CPU的计算能力。有关GPU的事情,我之后会请一位外部的嘉宾,就是NVIDIA的创始人和CEO黄仁勋先生,让他给大家介绍更多有关GPU的,尤其是在人工智能领域应用的情况。

百度大脑的第三部分是数据。数据也非常非常重要,而且这个数据量也是非常大的。比如说,我们已经收集了全网上万亿的互联网网页内容,这其中包括了很多视频、音频、图像,这些数据也是数以百亿级的。我们还有每天数十亿次网民的搜索请求,而且还有每天数百亿次的网民定位请求,就是说这个人在什么地方,这样的请求也比大家想象得多,每天都有好几百亿次这样的定位请求。

有了算法,有了计算能力,有了数据,百度大脑就可以开始工作了。百度大脑又到底有什么样的功能?让我们来看一看。

我们今天想重点介绍的四个功能:一个是语音的能力,一个是图像的能力,一个是自然语言理解的能力,还有一个就是用户画像的能力。这几个能力虽然都是属于人工智能中比较典型的应用,但是它的发展阶段也是很不一样的。比如说语音,现在就已经进入了相对比较成熟的阶段,在很多很多领域中都开始进入实用阶段,识别的准确率也已经很高了。图像最近几年也有了长足的进展。这两者都属于人工智能当中认知的部分,所以深度学习的算法非常适合处理这些形式。

相对来说,自然语言的理解、或处理能力就更加难一些,并处在一个更加早期的阶段,因为它除了认知方面的能力之外,还要求有推理、规划等等能力,才能够真正地理解自然语言。用户画像的能力,其实从传统意义上来讲并不是人工智能的领域,但是由于近年来大数据的发展,尤其是大型互联网公司有能力搜集很多用户的数据之后,再用人工智能的方法、用机器学习的方法,就可以把一个人的特征描绘得非常非常清楚。所以今天,用户画像也变成了人工智能、或者说变成了百度大脑的一个重要功能。

下面我就分别来讲一下这几个功能,这几个百度大脑的功能。

我们先看一下语音,刚才也讲了应该说今天人工智能发展的最成熟的一部分能力,而语音又分成两个方向,一个是语音的合成,一个是语音的识别。

我们先看看语音识别。今年MIT Technology Review(《MIT科技评论》)杂志,把百度的Deep Speech 2评为“2016改变世界十大突破技术”,这就是百度的语音识别引擎,它已经到了第二代,主要就是使用了深度学习的能力。这样的一个技术已经可以把语音识别的准确度做到多少呢?大概可以做到97%的准确率,这样的准确率已经达到、甚至有时已经超过了人对语音的识别能力。当然,我们讲这些能力不是为了简单地去炫耀这个数字有多好,我更感兴趣的是,当你有了这些能力时,它可以在什么领域应用,又可以在哪些方面帮助到我们,这其实才是最最让我们觉得兴奋的地方。我个人的想象力很有限,整个百度几万人的想象力也是有限的,但是这些能力如果赋予到很多很多人,赋予给几亿人、几十亿人,这个可能性几乎是无限的。先用我们比较有限的想象力来给大家举一个例子。

这是一个销售、电话销售的例子,是一个 2B(To B)的应用。这个应用是什么意思呢?很多的公司其实都有电话销售这样的一个部门,都需要这样做。但是销售,尤其是电话销售这个行业,大家知道流动性是比较大的,很多销售都是新人,新人的话就会经过一定的时间培训才能够上岗,但即使是经过培训的话,也不一定有那些有经验的销售那么出活儿、出单。其实有经验、最优秀的销售和一般、较差的销售相比,在效率上有非常大的差别。我们怎么才能够让新手、让没有经验的销售,能够具备最优秀销售的销售能力?过去的做法是,把优秀的销售经验总结成册子让大家去学习,让这些销售去背,但是怎么活学活用还是需要一个过程的。而有了这么高精度的语音识别能力之后,我们就可以彻底改变这样一个状况了,甚至可以让一个刚刚上岗一个月的销售就具备最优秀销售的能力,也就是说,我们可以通过实时的语音识别甄别出用户或客户在问什么问题,然后我们再实时地在屏幕上告诉新的销售,最优秀的销售是怎么回答这个问题的。过去没有实时的语音识别的时候,你需要线下学,学完了之后上去用、很容易就忘了,但是有了这个系统之后,我们就可以解决这样的问题。

我们来看一下这个案例。

大家看到,在刚才的过程中,百度大脑一直在实时地识别双方的对话,尤其是从电话里面传出来的声音,有的时候并不是那么清晰,对于人来说要完全听清楚每一个字其实都是有一定难度的,但百度大脑的语音识别能力已经可以做到非常精准,并且可以根据用户的问题、实时推荐下一步的工作要怎样应对,这是一个语音识别应用在企业日常运作中的一个例子,就像我刚才讲的,应该还有很多很多应用场景,大家可以根据自己的背景去想象。

语音识别是一方面,语音合成又是另外一个方面。语音合成是什么意思呢?就是机器可以把文字转换成语音,把它念出来、读出来。今天的语音合成也有了和过去非常不一样的体验,最主要的就是,它可以用比较自然的人的声音读出来,而不是像过去机器一样,每一个字之间的停顿都是一样长,是匀速的、没有表情的。这样的自然体验,当然对于用户的黏性来说也是有很大的作用。

现在,百度每天要响应2.5亿次的语音合成请求,这些请求用来干什么呢?比如说,过去人们看小说,今天可以在手机百度里面听小说。慢慢的人们听小说的时间也更长了,过去每个人平均在小说频道会花大概四十分钟左右的时间,现在要花将近两个半小时,就是因为把计算机合成出来的语音读出来给我们听,确实是一个很不错的体验,甚至是一种享受。那么这种读出来的小说,和我们平时听到的广播有什么本质上的不一样?其实非常不一样。广播是每一个人听到的东西是一模一样的,而今天的语音合成,它可以做到每一个人听到的东西都是不一样的,完全根据你个人的需求进行定制,这就是为什么它的(用户)黏性会很高,它能够具备自然发声的能力。不仅如此,其实我们可以想象一下,它如果能够模拟一个自然人的表达方式或发声能力,它就可以模拟任何一个你喜欢的人的说话方式。

不知道有没有人注意到,百度地图里导航功能就是用语音来进行的,其中有一个选项可以用我的声音进行导航。其实导航的那些话我并没有说过,机器只是根据我平时说话的情况合成了一个李彦宏的声音。这样的声音不仅在我身上可以做到,在很多其他人身上也可以做到。

我们现在来给大家展示一个合成的声音。我们合成了一下13年前已经去世的张国荣的声音,我们来放一段video。

为什么给大家展示这个呢?一方面我知道,很多人是张国荣的粉丝,另一方面,其实合成张国荣的声音比合成一般人的声音要更难。为什么呢?因为他的国语语料相对来说比较少,所以,我们能够合成他的声音,就一定能合成很多很多人的声音。

对于百度来说,百度大脑的语音合成能力可以让每个人都有自己的声音模型,你只要按照我们的要求说50句话,我就学会了你说话的方式。当你拥有自己的合成声音之后,比如说家里的老人想经常听你说一说,你把这个声音合成出来让他听就好了。或者说你平时要加班,小孩睡觉之前想听个故事,你合成自己的声音给孩子讲一遍这个故事,听起来也会很亲切。所以大家可以看到,这些语音的能力会带来各种各样新的可能性。

下面我给大家讲一下图像。用一个比较专业的术语来讲,我们叫做计算机视觉。这也是现在广义的人工智能中非常重要的领域。说到图像的识别,我想大家自然而然会反应出来一个什么应用呢?应该就是我们通常讲的人脸识别的应用。人脸识别的准确率今天已经达到了99.7%,已经非常非常准确了。现场的屏幕能够识别出来我们一些嘉宾,根据他们的人脸,我们知道这个人是谁,这个准确率已经比较高了。刚才进来的时候,大家也可以看到一些人脸识别的展台,我们是可以识别很多很多人的面孔的。

那么,人脸识别这个技术是怎么实现的?我们要对人脸的特征提取它的关键点,把这些点打出来之后要做一些处理,把它连成一个面部表情,据此来识别这样一个人。这就使得当一个人的表情发生变化的时候,我们仍然能够识别出来这个特点是没有发生变化的,比如他在哭,他在笑,他在愤怒,他在迷茫,他的表情是不一样的,但是他的表情特征是不变的,所以我们仍然可以很准确地识别出这样一个人。

除了面部识别之外,图像识别还在很多领域也有应用。我们再看一个,这是上海的一个全景图,大家使用百度地图有时候需要看这样一个景,到一个陌生的地方之前,想看看到那看到的样子是什么。当然,这个图不是一个简单的图像的采集,我们采集了图像之后要对图像中各种各样的目标进行识别,这个大楼是什么样的大楼,那个路牌上面写的什么字,对写的这个字识别的话,跟人脸识别还不太一样,这里面有一个特殊的图像识别的技术就是OCR,这个是二十多年前我们的一个专利,到今天它的准确率已经非常高了,下面我们也是用一段视频给大家看一下百度地图是如何利用图像识别的。

这是百度地图利用图像识别的情况,其实还有一个很重要的领域也是非常需要图像识别的技术,这个领域是什么呢?这就是我们过去一年来讲得比较多的无人驾驶汽车。无人驾驶汽车涉及到很多很多的技术,比如说我们需要计算机视觉的技术,需要高精度地图,需要对环境的感知,需要定位,甚至需要语音的通话。但应该说,计算机视觉或者是图像识别的技术是“最后一公里”,无人驾驶汽车真的要变成没有人,真的要能够解决99.999%、甚至100%的情况,最终还是要依靠计算机视觉的能力,要识别各种各样的极端的情况。

去年年底开始,我们给大家展示过百度的无人车在五环上跑,在高速上跑的情况,过去一年左右的时间我们也花了不少精力去提升我们在城市道路上运营的水平,下面我们也放一段视频给大家看一下。

大家看到左下角这是人能够看到的视野,这个视野其实是比较窄的,主屏幕是无人车能够看到的路面情况,大家可以感受到,它感知的范围其实比人要宽了很多,很多比较远的目标都可以感知到,每个目标都给出它唯一的编号进行识别。对面有什么车过来了,遇到红绿灯,遇到障碍怎么办,行人怎么能识别出来,或者是树木,周边的汽车等等,每一个目标我们都进行了识别和编号,这就是实际的、一个百度无人驾驶汽车在城市道路中行驶的情况,上面的45是限速。

这是大致的一个车看到的世界是什么样的。这里面涉及了很多计算机视觉或者是图像识别的技术,尤其是这两个技术:一个是我们叫做车辆的检测,你行驶过程中怎么能够知道旁边有车辆,这个车辆在哪?这个车辆的检测我们现在按照国际权威的评测来看,车辆检测的能力,百度无人车已经排名第一了。还有一个很重要的能力是车辆跟踪的能力。这个不仅是全自动的无人车,即使是对半自动的、高度自动驾驶来说,也是一个很基本的能力。你怎样能够准确地跟着前面的车走,这个技术在包括准确性、全面性、连续性等六项指标中,我们已经有四项拿到了第一。

这是无人车对于图像识别依赖的情况。我们再给大家展示一个领域,就是增强现实AR,AR其实也是非常依赖(图像识别)。拿着手机拍一下现实的情况,我们要能够识别出来这是哪,这里面有什么,然后才能跟用户进行互动,才能产生真实世界和一些虚拟世界的完美的结合。那么这个东西有什么应用呢?我们也觉得很高兴我们的周总、我们的广告主非常敏锐地把握到了这么一个机会,他说OK,我可以把现实世界中我的产品和虚拟世界中我希望用户感知的东西结合在一起,这样的一个做法也可以说是一种新型的广告形式,下面我们就来看一个具体的例子。这是我们跟欧莱雅中国合作的一个例子。我们放视频。

所以大家看到无论你拿手机拍一张明信片,还是拍一个实物的洗发水,它都可以准确地识别出来这个东西,和用户进行互动,这里面不仅有图像识别的技术,也很大程度上取决于广告主的创意,如果创意和这个技术结合,对消费者的吸引力也非常大,所以我们也期待将来的时间和客户很好地合作,把这个创意,把最优秀的想法和最优秀的技术结合起来,给消费者带来实惠。